.jpg)

現在この文章を読んでいるあなたは、きっとAIによるアート生成やそれらが2Dおよび3Dアーティストに影響しうる脅威についての議論を見たり聞いたりしたことがあるでしょう。この問題に対する不安もありますが、反対にこの新しい技術が私たちの創作を改善する方法も数多くあります。そして、Blenderコミュニティのユーザー達は既にAIをソフトウェアに直接統合する方法を見つけています!

.jpg)

AI RenderはBlenderのアドオンであり、Stable Diffusionを使用して、テキストの指示と3Dシーンの組み合わせで画像やアニメーションを生成することができます。セットアップも簡単で、魅力的な点は、ローカルにStable Diffusionをインストールして使用することもできます。ローカルインストールを利用する場合は、自分のハードウェアを使ってAI画像の処理を行う必要がありますが、それによって制限なく生成することができます。

先に進む前に、費用対効果が高く信頼性のあるガレージファームのBlenderのレンダーファームをおすすめします!新規ユーザーの方は、$50のレンダークレジットを獲得でき、短いアニメーションクリップや複数の静止画には十分です。また、私たちのクラウドレンダリングサービスには、24時間365日相談できる3Dの専門家チームが待機しており、いつでもご対応致します。

アドオンをダウンロードし、Blenderを管理者モードで起動します。環境設定パネルのアドオンタブから「インストール」を押して.zipファイルをインストールし、zipをインポートしてください。

アドオンを有効にして、「設定」パネルを確認してください。

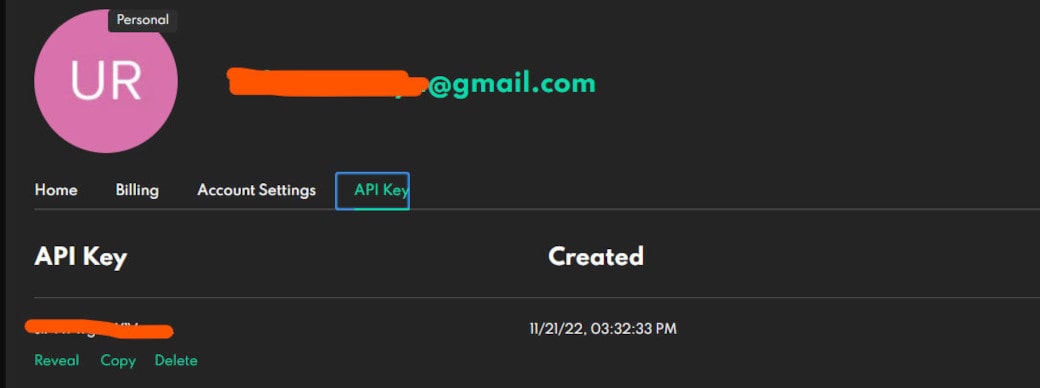

塗りつぶされたフィールドには、Dream Studioの私の個人用のAPIキーが記載されています。このアドオンを使用するには、独自のキーが必要です。

Dream Studioでアカウントを作成してください。アカウントを設定したら、プロフィールアイコンをクリックし、ドロップダウンメニューから「メンバーシップ」を選択してください。

メンバーシップのページで、APIキーのタブが表示されるので、APIキーをコピーしてください。

Blenderの環境設定パネルのアドオン設定の欄にAPIキーを貼り付け、環境設定を保存すれば完了です!

あなたのDream Studioのアカウントには、$2分のクレジットが付属しています。これは約200回の生成に相当します。クレジットを使い果たしたら、追加の購入が必要になります。ただし、ローカルインストールのStable Diffusionを使用するオプションもあり、その設定方法に関する説明へのリンクもあります。この方法にはさらに多くの手順が必要ですが、それに従って設定すれば、ワークステーションのリソースを使って無料でAI画像を生成することができます。

もし、これに関する詳細を知りたい場合は、YouTuberのRoyal Skiesがこのプロセスをうまく説明しています!また、よくある問題や解決方法もコメント欄に残してくれています。

これは、私が苦労しているプロジェクトのテストレンダリングです。全体的な構図や羊にもっと手を加える必要があることに加え、私が最も頭を悩ませているのは、キャラクターの衣装デザインです。正直なところこれは私の得意分野ではないので、こんな時にAIを活用することができます。

まず、AIレンダリングに必要な512×512ピクセルでキャラクターを分離してレンダリングします。

これは、プロンプトの助けを借りてAIレンダリングを進化させるための基礎となります。

AIアートジェネレーターを初めて使うなら、少なくとも最初の数枚は、思いつくままに試してみることをお勧めします。

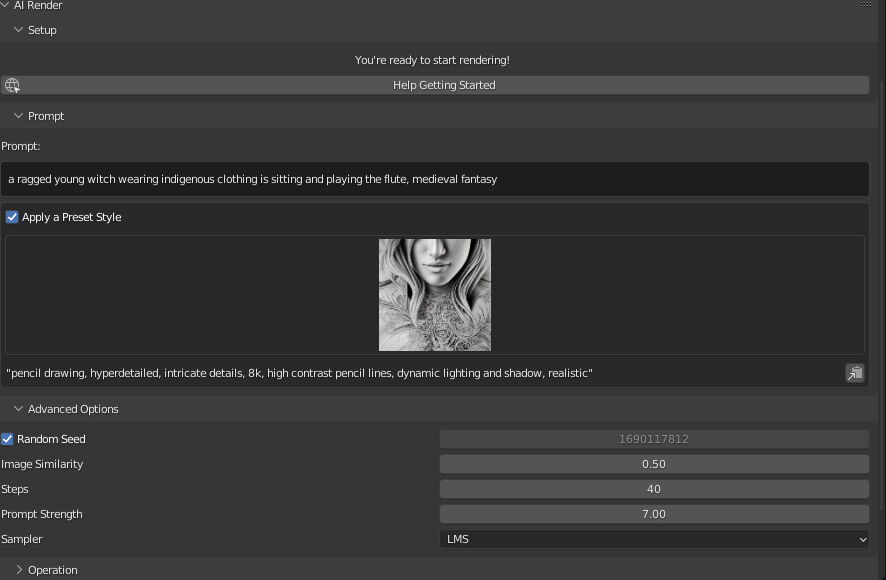

AIアートジェネレーターには、生成結果に一貫して影響を与える特定のキーフレーズがあります。これらのジェネレーターにはプリセットが付属していることが多く、これはAIを特定の視覚効果に誘導するように設計されたプリセットです。例えば、AIレンダーアドオンでは、特定のフレーズを組み込んだプリセットを使用して、AIを特定の外観やスタイルに誘導しています。

このAIレンダーの設定画面には、一番上の初期プロンプト、選択したプリセットスタイル、そしてそのスタイルを構成する対応するプロンプトが表示されています。私は特に鉛筆画のようなスタイルにしたいわけではないので、自分のニーズに合ったフレーズを選び、手動でプロンプトに追加していくことにします。

「先住民族の服を着たぼろぼろの若い魔女が座ってフルートを吹いている。中世のファンタジー。非常に詳細でダイナミックな照明と影。リアルな描写。」

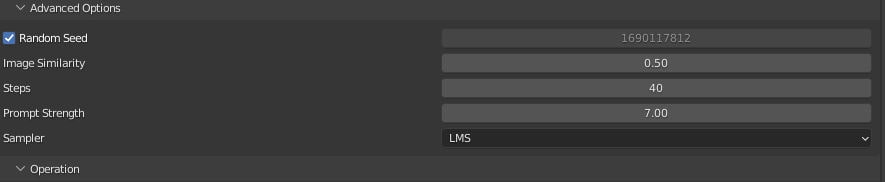

詳細オプションのドロップダウンには、結果をある程度コントロールできるようにするためのパラメータがいくつか用意されています。

Random Seed(ランダムシード) - この設定を有効にすると、各生成結果がランダムになります。ただし、反復処理間の結果の一貫性を保ちたい場合は、この設定を無効にしてください。

Image Similarity(画像の類似性) - これは、最初の画像とプロンプトの間の範囲を調整するスライダーとして考えてください。低い値に設定すると、生成される出力には、最初の画像の特性がより多く反映されます。一方、高い値を設定すると、プロンプトの特性が優先され、提供されたプロンプトが大きく影響します。

Steps(ステップ) - 画像の品質に影響します。 アドオンの開発者は、25 ~ 50 の範囲にしておくことを推奨しています。

Prompt Strength(プロンプト)は、プロンプトにどれだけ忠実に従うかを決定します。 正の値はプロンプトに強く従うことを示し、負の整数を使用すると、AI はプロンプトに示された内容を遵守しようとするのではなく、プロンプトに示された内容を回避します。

Sampler(サンプラー) - AI が使用するサンプリング方法から選択できます。

デフォルトでは、Render AIはレンダリングが完了すると、その上に新しいレンダリングを生成します。しかしこの場合、すでにベースとなる画像をレンダリングしているため、レンダリングプロセスを何度も繰り返す必要はありません。そのため、既存のレンダリングをベースに追加で画像を生成するか、AIが生成した既存の画像をベースに全く新しい画像を生成するか、どちらかを選択することができます。

“Apply a Prompt Style(プロンプトのスタイルを適用する)”のチェックを外した後、 “New Image From Last Render(前回のレンダリングから新しい画像)”を押すと、このような結果になりました:

この記事を書いている時点では、人体構造上の生成に多少の狂いがあることは予想されますが、生成された画像の衣装は、私が以前にレンダリングしたものと比べて、すでに改善されています。しかし、もう少し色が欲しいので、プロンプトに「カラフル」を追加することにします:

「カラフルな先住民の服を着たボロボロの若い魔女が座って笛を吹いている。中世のファンタジー。非常に詳細でダイナミックな照明と影。リアルな描写。」

今回は衣装のディテールのイメージを残すために、”New Prompt From Last AI image(前回のAI画像からの新しいプロンプト)’’を使用することにします。

あまりうまくいきませんでした。 レンダリングからの生成に戻り、今度は「Photorealistic」プロンプト スタイルから取得したプロンプト「Canon 50mm レンズ」を追加します。

だいぶ良くなりましたね!

これらの結果から、時間をかけてさらにイメージを生成し、前の生成からベース レンダーに移行して、今後の参考のために気に入ったイメージを保存しました。 キャラクターの衣装のより良いデザインのためのマテリアルが十分集まるまで、プロンプトを時々調整しました。

コンセプトを最も惹かれた4つのイメージに絞り込み、Blenderでキャラクターの最初のバリエーションを作成しました。

私的には、最初のコンセプトから大きく改善されたのですが、このAI生成にどんどん興味が湧いてきました:

その結果、シーン全体のコンセプトが固まりました:

以前は、インターネットで写真を検索して参考にしていましたが、AIを活用してコンセプトを反復することで、より早くさまざまなアイデアを探求し、デザインに集約させることができることがわかりました。また、画像の生成にはある程度の自分で介入することが必要になるため、特定のコンセプトに熱中しやすくなり、最終的なレンダリングまでやり遂げる意欲が湧くようになりました。

CGアートの分野でのAI技術の急速な進歩は、良い面も悪い面もありますが、今回の活用事例をきっかけに、より楽観的な視点で見ていただければと思います。情報収集と適応力を維持しながら、クリエイティブな活動を続けていくことが重要です。